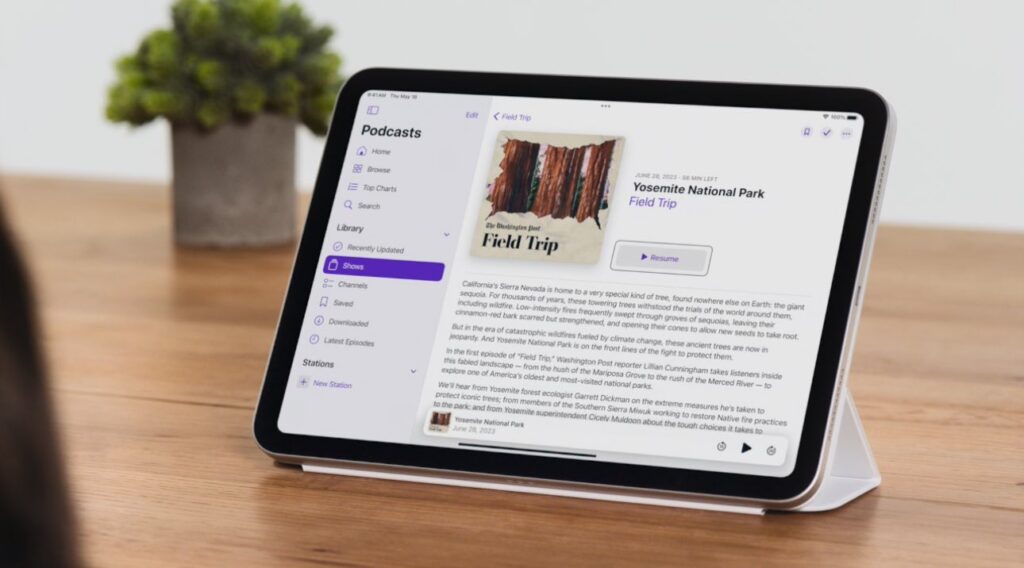

La tecnología avanza cada vez más y de manera impresionante, el sistema operativo iOS 18 de Apple introducirá en su siguiente actualización el seguimiento ocular o ‘Eye Tracking’, una opción de accesibilidad que permitirá navegar y controlar con los ojos las tabletas iPad y los teléfonos iPhone.

Ahora, el gigante tecnológico indicó que la función llegará a finales de este año y está enfocada a los usuarios con discapacidades físicas. Se calibra en segundos a través de la cámara frontal de los dispositivos y funciona combinando el poder del ‘hardware’ y ‘software’ y aprovechando «la inteligencia artificial y el aprendizaje automático de Apple». «Porque creemos que la mejor tecnología funciona para todos», dijo la compañía en un video como abreboca del ‘Eye Tracking’. De esta forma, los usuarios con ‘Eye Tracking’, podrán navegar a través de los elementos de una aplicación y usar la función ‘Dwell Control’, que facilita la realización de acciones al navegar exclusivamente con los ojos, para activar cada elemento, acceder a funciones adicionales como botones físicos, deslizarse, entre otros, detalla la compañía de Cupertino.

Sin embargo, el seguimiento ocular no requiere ningún tipo de accesorio o ‘hardware’ adicional. Todos los datos del escaneo utilizados para configurar y controlar «no se comparten con Apple» y se guardan de forma segura únicamente en el dispositivo.

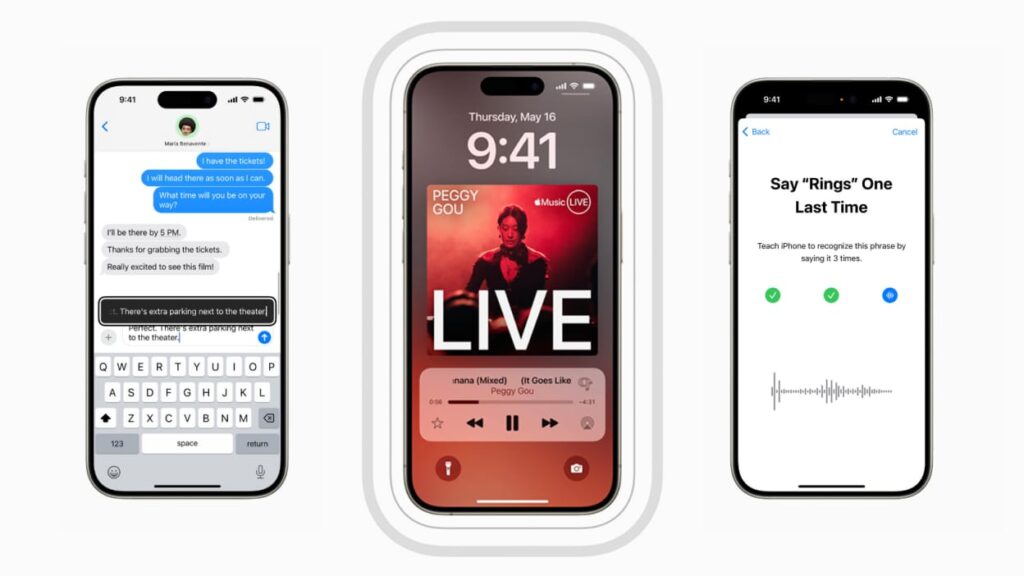

Además, esta característica llegará junto con otras funciones de accesibilidad, entre las que se encuentra ‘Music Haptics’, una nueva forma para que los usuarios sordos o con problemas de audición escuchen música en el iPhone, reproduciendo «toques, texturas y vibraciones refinadas al audio de la música». Funciona en millones de canciones del catálogo de Apple Music.

Como también, Apple introducirá «atajos vocales», que permitirán asignar expresiones personalizadas para tareas complejas. Además, se ofrecerá la opción de mejorar el reconocimiento de voz para aquellos con afecciones adquiridas o progresivas de habla, como parálisis cerebral, esclerosis lateral amiotrófica o accidente cerebrovascular, que tengan una «voz atípica».

De esta forma, se utiliza el aprendizaje automático del dispositivo para reconocer los patrones de habla del usuario. «Brindan un nuevo nivel de personalización y control», subraya Apple.